Kommentar des Autors

Dieser Ansatz funktioniert gut für einzelne Funktionen mit kurzen Argumenten. Wenn jedoch die Argumentlänge zunimmt, neigen LLMs dazu, den Text zu verkürzen oder zusammenzufassen, wodurch wichtige Details verloren gehen können. Das gesamte ursprüngliche Benutzeranliegen als Kontext zu übergeben, kann "Rauschen" einführen und die Genauigkeit der Argumentextraktion verringern.

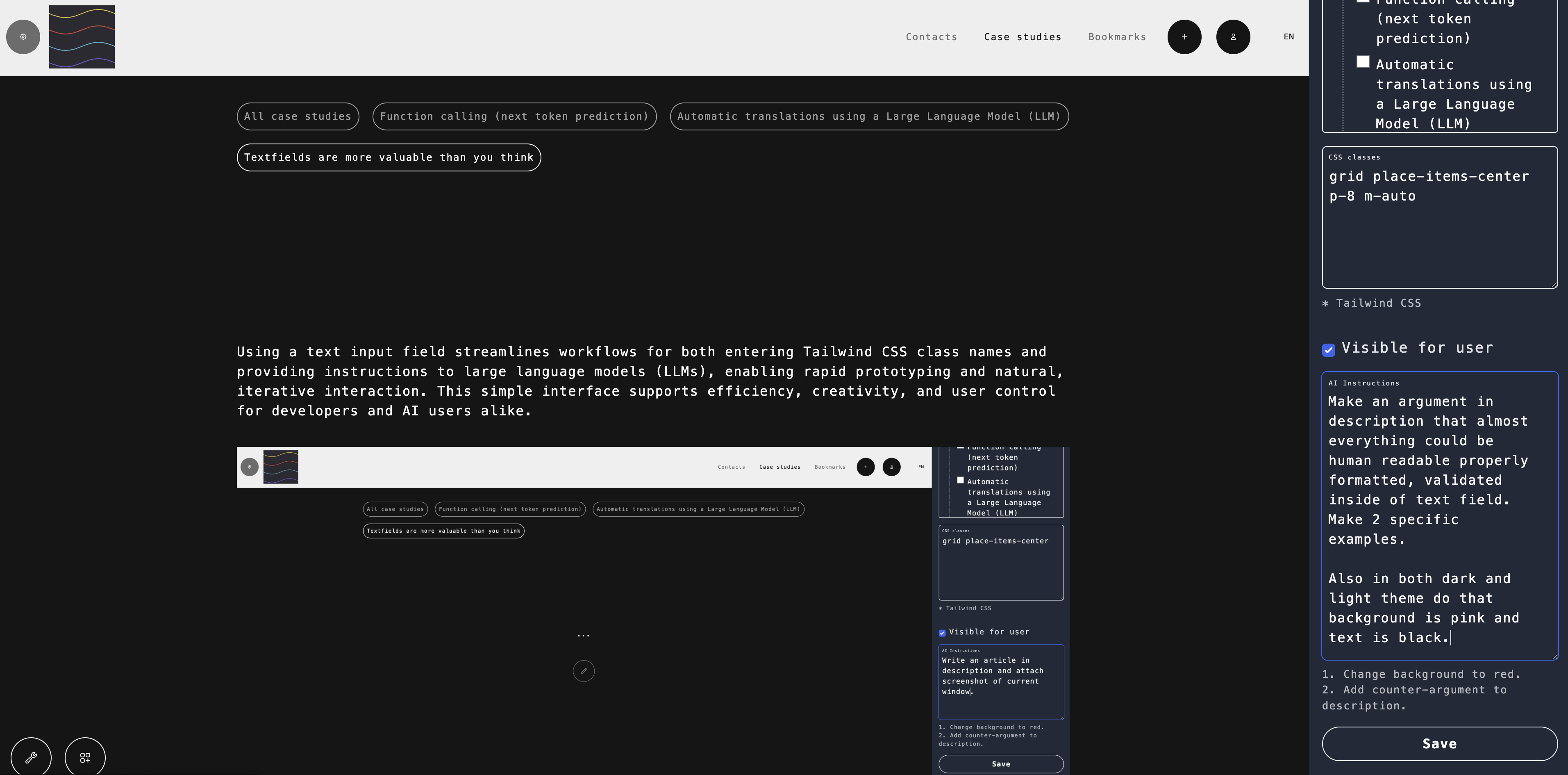

Könnte ein Maß für Intelligenz sein, "zu verstehen, welche Funktionen zu verwenden sind und mit welchen Parameterwerten", wobei dies durch die "verfügbaren Funktionen" begrenzt ist?

Siehe auch: