Comentário do autor

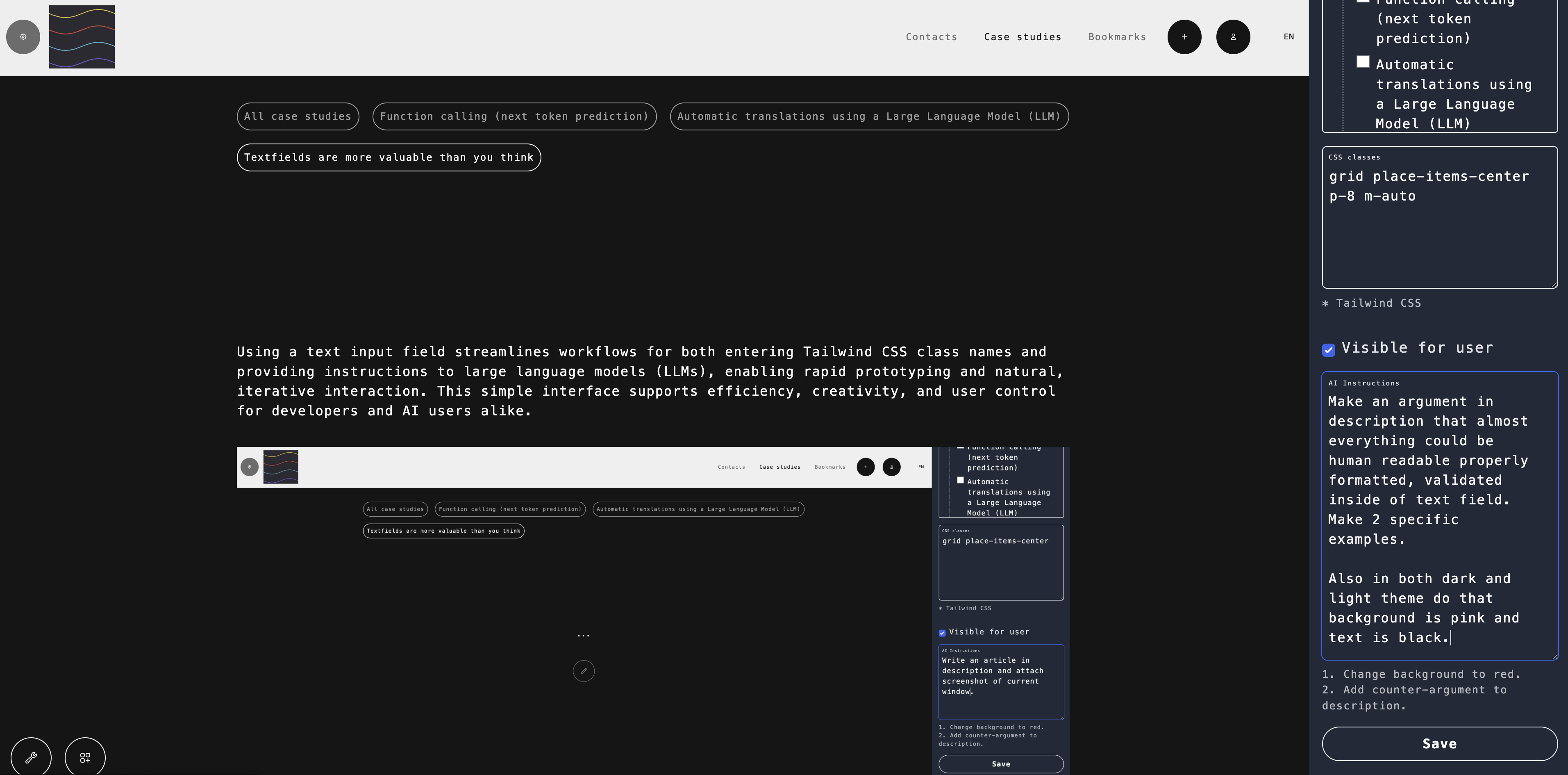

Essa abordagem funciona bem para funções únicas com argumentos curtos. No entanto, quando o comprimento dos argumentos aumenta, os LLMs tendem a encurtar ou resumir o texto, podendo perder detalhes importantes. Passar todo o pedido inicial do usuário como contexto pode introduzir "ruído" e reduzir a precisão da extração de argumentos.

Uma possível medida de inteligência seria "entender quais funções usar e com quais valores de parâmetros", sendo limitada pelas "funções disponíveis"?

Também assista: